Was ist eine robots.txt Datei und warum ist sie so wichtig?

Stell dir vor, du veranstaltest eine große Party. Du möchtest, dass deine Gäste die Party genießen, aber bestimmte Bereiche, wie dein Schlafzimmer oder das Büro, sollen privat bleiben. Die robots.txt Datei ist wie der freundliche Türsteher deiner Website. Sie begrüßt die "Gäste" – in diesem Fall die Crawler von Suchmaschinen wie Google, Bing & Co. – und sagt ihnen höflich, wo sie sich umsehen dürfen und welche Bereiche sie bitte meiden sollen.

Technisch gesehen ist die robots.txt eine einfache Textdatei, die du im Hauptverzeichnis (Root-Verzeichnis) deiner Website ablegst. Sie ist das Erste, wonach ein Suchmaschinen-Bot sucht, wenn er deine Seite besucht. Obwohl die Anweisungen in der robots.txt für seriöse Crawler wie Googlebot oder Bingbot bindend sind, können sich "böse" Bots einfach darüber hinwegsetzen. Deshalb ist die robots.txt kein Sicherheitsmechanismus, sondern ein Werkzeug zur Steuerung des Crawlings und für wichtige grundlegende SEO-Maßnahmen.

In diesem robots.txt SEO Artikel erfährst du:

Warum die robots.txt für SEO unverzichtbar ist

Wie eine robots.txt Datei aufgebaut ist (Syntax einfach erklärt)

Praktische Beispiele für deine robots.txt

Wie du eine robots.txt Datei erstellst

Die häufigsten Fehler und wie du sie vermeidest

Robots.txt vs. "noindex"-Meta-Tag: Was ist der Unterschied?

Wie du deine robots.txt Datei testen kannst

Wie du deine robots.txt automatisch mit einer Prompt-Vorlage erstellst

Wie du nachhaltigen SEO- und AEO Erfolg sicherst

Warum die robots.txt für SEO unverzichtbar ist

Eine korrekt konfigurierte robots.txt Datei kann deine SEO-Performance erheblich verbessern. Hier sind die wichtigsten Vorteile:

Schutz sensibler Bereiche

Bestimmte Bereiche deiner Website, wie z.B. Admin-Bereiche oder Testumgebungen, sind nicht für die Öffentlichkeit bestimmt. Die robots.txt ist der erste Schritt – neben dem 'noindex'-Meta-Tag – um diese Bereiche vor Suchmaschinen zu "verstecken".

Kontrolle über Suchergebnisse

Bestimme, wie deine Website in den Suchergebnissen erscheint. Indem du unwichtige Seiten wie Tag- oder Kategorie-Archive blockierst, sorgst du für ein sauberes und professionelles Bild und lenkst Besucher direkt auf die relevantesten Inhalte.

Vermeidung von Duplicate Content

Oft existieren mehrere Versionen einer Seite (z.B. eine Druckversion oder Seiten mit URL-Parametern). Mit der robots.txt kannst du verhindern, dass diese doppelten Inhalte gecrawlt und indexiert werden, was deine Rankings negativ beeinflussen könnte.

Wie eine robots.txt Datei aufgebaut ist (Syntax einfach erklärt)

Die Syntax der robots.txt ist einfach und besteht hauptsächlich aus zwei Anweisungen ("Direktiven"):

- User-agent: Definiert, für welchen Crawler (Bot) die nachfolgenden Regeln gelten. Ein Sternchen (*) spricht alle Bots an.

- Disallow: Verbietet das Crawlen eines bestimmten Verzeichnisses oder einer Datei.

- Allow: Erlaubt das Crawlen, auch wenn das übergeordnete Verzeichnis blockiert ist.

Wichtige Sonderzeichen:

*(Sternchen): Dient als Platzhalter für eine beliebige Zeichenfolge./(Schrägstrich): Steht für das Hauptverzeichnis deiner Website.#(Raute): Leitet einen Kommentar ein, der von den Crawlern ignoriert wird.$(Dollarzeichen): Markiert das Ende einer URL.

Praktische Beispiele für deine robots.txt

| Anwendungsfall | Code für die robots.txt |

|---|---|

| Alle Crawler von der gesamten Website aussperren | User-agent: * |

| Alle Crawler auf der gesamten Website zulassen | User-agent: * |

| Ein bestimmtes Verzeichnis sperren | User-agent: * |

| Eine bestimmte Datei sperren | User-agent: * |

| Den Googlebot von einem Verzeichnis ausschließen | User-agent: Googlebot |

| Alle PDF-Dateien sperren | User-agent: * |

| Pfad zur Sitemap angeben | Sitemap: https://www.deine-website.com/sitemap.xml |

Wie du eine robots.txt-Datei erstellst und wo du sie speicherst

Das Erstellen einer 'robots.txt' ist einfacher, als du denkst. Du kannst sie manuell anlegen oder dir sogar von einem KI-Chatbot generieren lassen. Egal welchen Weg du wählst, hier ist, was du wissen musst:

1. Manuelle Erstellung in 4 Schritten

Für eine grundlegende 'robots.txt' reichen oft schon wenige Zeilen:

- Öffne einen einfachen Texteditor (wie Notepad unter Windows oder TextEdit auf dem Mac).

- Schreibe die gewünschten Direktiven in die Datei (siehe die Beispiele oben).

- Speichere die Datei unter dem exakten Namen robots.txt ab. Achte darauf, dass keine weitere Endung wie '.txt.txt' angehängt wird.

- Lade die 'robots.txt'-Datei mit einem FTP-Programm oder über den Dateimanager deines Hosters in das Stammverzeichnis (root directory) deiner Website hoch.

2. Einfacher geht's mit dem KI-Chatbot (Copy & Paste Prompt)

Wenn du dir unsicher bist oder eine schnelle, maßgeschneiderte 'robots.txt' brauchst, kann ein KI-Chatbot wie Google Gemini, ChatGPT, Perplexity oder ähnliche Tools ein fantastischer Helfer sein. Unten findest du eine Prompt-Vorlage für die automatische Erstellung deiner robots.txt innerhalb weniger Sekunden.

3. Wo die robots.txt gespeichert werden muss

Egal wie du deine 'robots.txt' erstellst, der Speicherort ist entscheidend:

Du musst die Datei in das Hauptverzeichnis (Root-Verzeichnis) deiner Website hochladen. Sie muss unter der URL 'https://www.deine-website.com/robots.txt' (ersetze 'deine-website.com' durch deine Domain) direkt erreichbar sein. Andernfalls können Suchmaschinen-Bots sie nicht finden und deine Anweisungen ignorieren.

Die häufigsten Fehler in der robots.txt und wie du sie vermeidest

Versehentliches Blockieren der gesamten Website

Ein falscher Schrägstrich kann fatal sein. Disallow: / sperrt alles. Überprüfe deine Anweisungen immer doppelt.

Blockieren von CSS- und JavaScript-Dateien

Google möchte deine Website so sehen wie ein Nutzer. Blockierst du CSS oder JS, kann Google die Seite nicht korrekt rendern, was zu schlechteren Rankings führen kann.

Falscher Speicherort der robots.txt

Die robots.txt Datei gehört immer in das Hauptverzeichnis deiner Domain, nicht in einen Unterordner.

Tippfehler in der robots.txt vermeiden

Die Direktiven sind case-sensitive. user-agent ist falsch, User-agent ist richtig.

Robots.txt vs. "noindex"-Meta-Tag: Was ist der Unterschied?

Ein häufiges Missverständnis ist, dass man mit Disallow in der robots.txt eine Seite aus den Suchergebnissen entfernen kann. Das ist falsch!

- robots.txt (Disallow): Verhindert das Crawlen. Die Seite kann aber trotzdem indexiert werden, wenn sie von anderswo verlinkt ist.

- "noindex"-Meta-Tag: Verhindert die Indexierung. Die Seite wird gecrawlt, aber nicht in den Suchergebnissen angezeigt

<meta name="robots" content="noindex">

Faustregel: Wenn eine Seite nicht gecrawlt, aber indexiert werden darf, nutze die robots.txt. Wenn eine Seite nicht in den Suchergebnissen erscheinen soll, nutze das "noindex"-Meta-Tag auf den betreffenden Seiten.

Wie du deine robots.txt-Datei testen kannst

Bevor du deine 'robots.txt' Datei live schaltest, ist ein Test unerlässlich, um sicherzustellen, dass du nicht versehentlich wichtige Seiten blockierst oder Fehler in der Syntax hast. Hier sind zwei moderne und effektive Methoden, um deine Datei zu überprüfen:

1. Semantische Prüfung mit einem KI-Chatbot

Eine der schnellsten Methoden, um die Logik und Syntax deiner 'robots.txt' zu überprüfen, ist die Nutzung eines KI-Chatbots wie Google Gemini, ChatGPT oder Perplexity. Du kannst einfach den Inhalt deiner 'robots.txt' kopieren und die KI bitten, ihn zu analysieren.

"Analysiere die folgende robots.txt-Datei. Ist die Syntax korrekt? Welche Verzeichnisse werden für den Googlebot blockiert? Gibt es potenzielle Probleme, die mein SEO beeinträchtigen könnten?"

User-agent: *

Disallow: /admin/

Disallow: /warenkorb/

User-agent: Googlebot

Allow: /wp-admin/admin-ajax.php

Sitemap: https://www.deine-website.com/sitemap_index.xmlDie KI wird dir sofort eine verständliche Erklärung liefern, ob deine Regeln logisch sind und was sie genau bewirken. Das ist ideal für eine schnelle erste Überprüfung.

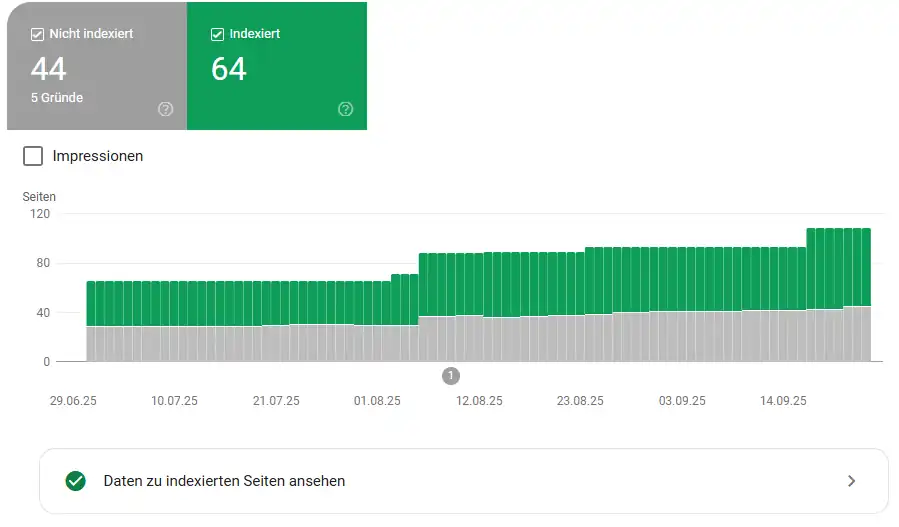

2. Indexierungs-Status in der Google Search Console prüfen

Um zu sehen, wie Google deine Seiten tatsächlich indexiert, ist die Google Search Console das ultimative Werkzeug. Hier siehst du nicht nur, *ob* eine Seite blockiert ist, sondern auch, *warum*.

- Melde dich in der Google Search Console an.

- Navigiere im Menü auf der linken Seite zu Indexierung > Seiten.

- Hier siehst du eine detaillierte Übersicht, wie viele deiner Seiten indexiert und wie viele nicht indexiert wurden.

- Scrolle nach unten zum Abschnitt "Warum Seiten nicht indexiert werden". Hier listet Google Gründe auf, wie z.B. "Durch 'noindex'-Tag ausgeschlossen" oder "Durch robots.txt-Datei blockiert".

Diese Ansicht ist extrem wertvoll, um zu verstehen, ob deine 'robots.txt'-Anweisungen wie erwartet funktionieren und um andere Indexierungsprobleme zu identifizieren. So stellst du sicher, dass Suchmaschinen deine Website genau so sehen, wie du es beabsichtigst.

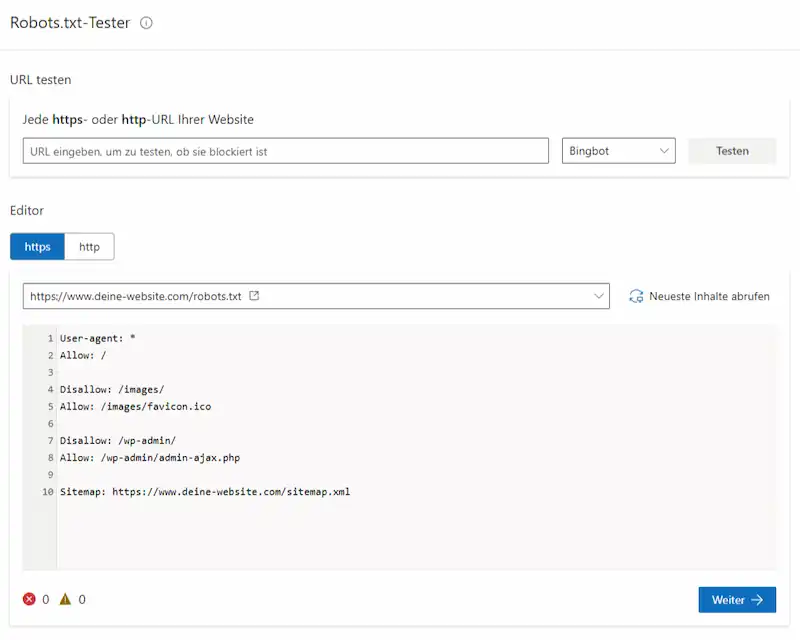

3. Live-Test mit dem Bing Webmaster Tools Robots.txt-Tester

Auch Microsoft bietet mit den Bing Webmaster Tools einen eigenen, sehr nützlichen Robots.txt-Tester. Dieses Tool simuliert, wie der Bingbot deine Seite crawlt und zeigt dir sofort, ob eine URL blockiert wird. Außerdem siehst du sofort, ob du bereits eine robots.txt Datei auf deinem Webserver hast und was darin konfiguriert ist.

- Öffne den Robots.txt-Tester in den Bing Webmaster Tools.

- Navigiere im Menü auf der linken Seite zu Tools und Erweiterungen > Robots.txt-Tester.

- Gib eine spezifische URL deiner Website ein, die du testen möchtest, klicke auf "Testen" und du siehst sofort, ob der Bingbot Zugriff hat (Allowed) oder blockiert wird (Disallowed).

- Im Editor siehst du, ob du schon eine robots.txt hast, was diese enthält und ob sie kritische Fehler enthält.

- Bei Bedarf kannst du auf "Weiter" klicken, die robots.txt herunterladen, bearbeiten und nach erneutem Hochladen kannst du eine Bing-Aktualisierung anfordern.

Dieser Test ist besonders praktisch, um die Regeln für verschiedene Suchmaschinen zu überprüfen und sicherzustellen, dass deine Anweisungen korrekt interpretiert werden.

⭐ Deine KI-Chatbot Prompt-Vorlage für die robots.txt

Ich betreibe als [Start-up|EPU|KMU] meine eigene Website [deine-website.com] und möchte eine robots.txt-Datei erstellen. Bitte erstelle mir ein Schritt-für-Schritt-Tutorial in Textform für eine Zielgruppe ohne technische Webdesign-/SEO-Kenntnisse, das folgende Punkte abdeckt:

1. Was ist eine robots.txt-Datei? Warum ist sie wichtig für SEO? Kurze Erklärung mit den 3 wichtigsten Punkten.

2. Welche Befehle sollte ich unbedingt einfügen? (z.B. Erlaubnis für alle Crawler, Ausschluss von Beispielordner wie /admin oder /tmp)

3. Erstelle ein einsatzbereites Beispiel für eine vollständige robots.txt-Datei mit folgenden Bedingungen:

* Alle Suchmaschinen dürfen die Website durchsuchen.

* Die Ordner /admin und /tmp [hier deine zu blockierenden Ornder angeben] sollen blockiert werden.

* Die Sitemap unter https://[deine-website.com]/sitemap.xml soll angegeben werden.

4. Wie kann ich die Datei testen, um sicherzugehen, dass sie korrekt funktioniert? (z.B. mit Bing Webmaster Tools oder Google Search Console)

5. Wie lade ich die Datei hoch und bearbeite sie, je nach System:

* Für händisch erstellte Websites (z.B. mit HTML/CSS)

* Für WordPress

* Für Jimdo

* Für Wix

* Für Squarespace

* Für Webflow

6. Achte bitte darauf, dass ich die Datei am Ende einfach kopieren und im Hauptverzeichnis meiner Website speichern kann.

WICHTIG: Ersetze im Prompt "[deine-website.com]" und alle anderen Infos, die in eckigen Klammern stehen "[...]" mit deinen spezifischen Daten! Der Chatbot wird dir eine maßgeschneiderte 'robots.txt' generieren und wertvolle Hinweise geben.

Fragen? Neugierig? Zusammenarbeit?

🚀 Deine Website verdient mehr Sichtbarkeit!

Optimiere deine 'robots.txt' und weitere SEO-Maßnahmen für Top-Rankings.

Du möchtest sicherstellen, dass Suchmaschinen deine wichtigsten Seiten finden und unwichtige links liegen lassen? Mit der richtigen SEO-Strategie holen wir das Maximum aus deiner Website – inkl. 'robots.txt' – heraus. Sie ist dein digitaler Türsteher für Google, Bing & Co. Ist sie falsch konfiguriert, bleiben deine besten Inhalte unsichtbar.

- Ranking-Potenzial entfesseln: Gemeinsam sorgen wir dafür, dass deine Website die Aufmerksamkeit bekommt, die sie verdient.

- Indexierungsfehler vermeiden: Alle wichtigen Inhalte von Google, Bing & Co. crawlen lassen, statt sie versehentlich auszusperren.

- Klare Wegweisung per Sitemap: Die Sitemap darf in keiner robots.txt fehlen, sie zeigt Google, Bing & Co. den schnellsten Weg zu deinen relevanten Seiten.

📈 Starte noch heute deinen Weg zu besserer Sichtbarkeit und mehr Kunden online.

Entdecke mein SEO & AEO Angebot für deinen perfekten Online-Auftritt

SEO & AEO Leistungen für deine Top Sichtbarkeit in Google, Bing & KI-Antworten auf ChatGPT, Perplexity, Google AI Overviews und AI-Mode.

Entdecke alle SEO & AEO Tipps und Tricks für dein Unternehmen

Alle Webdesign Tipps & Trends entdecken

Warum SEO wichtig ist – für kleine und große Unternehmen

Was kostet SEO wirklich? Der ultimative Preisleitfaden 2025!

Mit Local SEO & Google Business Profile zur regionalen Nr. 1

Die wichtigsten SEO und AEO Trends für 2025

AEO- und Position-Zero-ready mit FAQs und Featured Snippets

Was ist eine robots.txt Datei? DIY-Guide inkl. Prompt-Vorlage!

Instagram setzt jetzt auf SEO

Gratis Website SEO & Speed Analyse